TP5: Mélanger le réel au virtuel (English version) Posez une question sur ce TP!

HW5: Adding virtual objects (Version française) Ask us a question!

Résumé

Le but de ce projet est de vous familiariser avec les images à haute plage dynamique (High Dynamic Range ou HDR), l'éclairage à base d'images (Image Based Lighting ou IBL), et de leurs applications. À la fin de ce travail, vous serez en mesure de créer des images HDR à partir d'ensembles d'images à plage dynamique faible (Low Dynamic Range ou LDR) et, aussi, d'ajouter des objets 3D dans les photos en utilisant des techniques d'éclairage à base d'images.

La photographie HDR est la méthode de capture des photos contenant une plage dynamique plus grande que ce que les photos normales contiennent (c'est-à-dire qu'elles contiennent des valeurs de pixels en dehors de la plage standard des images LDR entre 0-255 et contiennent plus de précision). La plupart des méthodes pour créer des images HDR impliquent la fusion de plusieurs images LDR à diverses expositions, ce que vous ferez dans ce projet.

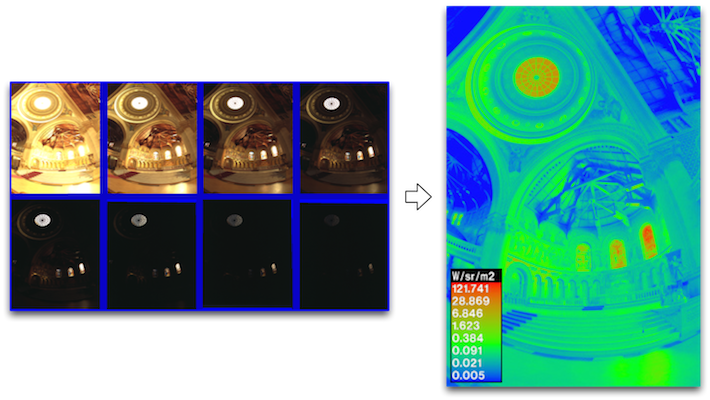

Les images HDR sont utilisées dans une grande variété d'applications, telles que l'amélioration du contraste, l'art hyper-réaliste, des ajustements d'intensité post-traitement, et l'éclairage à base d'images. Nous allons nous concentrer sur leur utilisation dans l'éclairage à base d'images, spécifiquement sur la "ré-illumination" d'objets virtuels. Une façon de ré-illuminer un objet est de capturer une image HDR panoramique 360 degrés (omnidirectionnelle) d'une scène qui fournit des informations d'éclairage sur tous les angles incident à la caméra (d'où le terme éclairage à base d'images). La capture d'une telle image est difficile avec des caméras standards, car cela nécessite à la fois de l'assemblage de photos et de la conversion LDR à HDR. Une alternative plus facile consiste à capturer une photographie HDR d'un miroir sphérique ce qui fournit les mêmes informations d'éclairage omnidirectionnel.

Dans ce TP, nous utiliserons l'approche du miroir sphérique. Une image HDR de ce miroir nous permettra de ré-illuminer des modèles 3D et de les composer harmonieusement dans des images.

Le travail à effectuer est divisé en trois étapes principales:

- Capturer plusieurs expositions d'une sphère métallique;

- Convertir les images capturées en une carte de radiance à haute plage dynamique ;

- Effectuer le rendu d'objets artificiels dans une photo en utilisant cette carte de radiance.

Ces étapes sont décrites plus bas.

Overview

The goal of this project is to familiarize yourself with high dynamic range (HDR) imaging, image-based lighting (IBL), and their applications. By the end of this project, you will be able to create HDR images from sequences of low dynamic range (LDR) images and also learn how to composite 3D models seamlessly into photographs using image-based lighting techniques.

HDR photography is the method of capturing photographs containing a greater dynamic range than what normal photographs contain (i.e. they store pixel values outside of the standard LDR range of 0-255 and contain higher precision). Most methods for creating HDR images involve the process of merging multiple LDR images at varying exposures, which is what you will do in this project.

HDR images are widely used by graphics and visual effects artists for a variety of applications, such as contrast enhancement, hyper-realistic art, post-process intensity adjustments, and image-based lighting. We will focus on their use in image-based lighting, specifically relighting virtual objects. One way to relight an object is to capture an 360 degree panoramic (omnidirectional) HDR photograph of a scene, which provides lighting information from all angles incident to the camera (hence the term image-based lighting). Capturing such an image is difficult with standard cameras, because it requires both panoramic image stitching and LDR to HDR conversion. An easier alternative is to capture an HDR photograph of a spherical mirror, which provides the same omni-directional lighting information (up to some physical limitations dependent on sphere size and camera resolution).

In this homework, we will take the spherical mirror approach. With this panoramic HDR image, we can then relight 3D models and composite them seamlessly into photographs.

This homework is divided into three main steps:

- Capturing multiple exposures of a metallic sphere;

- Converting these exposures into a single HDR radiance map;

- Rendering synthetic objects into a photograph using this panoramic radiance map.

The steps are described in more details below.

1. Capturer plusieurs expositions d'une sphère métallique

1. Capturing multiple exposures of a metallic sphere

Matériel nécessaire

Ce dont vous avez besoin :

- Un miroir sphérique (une boule de Noël réfléchissante devrait très bien faire l'affaire).

- Une caméra vous permettant de contrôler l'exposition. Cette option est disponible sur tous les appareils photographiques à réflexe numérique (DSLR en anglais), la plupart des appareils photo compacts et même sur la plupart des téléphones intelligents en utilisant une application adaptée.

- Un trépied, une surface rigide ou des mains très stables

Necessary equipment

You will need:

- Spherical mirror (a shiny Christmas ornament should do the trick).

- Camera with exposure control. This is available on all DSLRs (Digital single-lens reflex camera) and most point-and-shoots, and even possible with most mobile devices using the right app.

- Tripod / rigid surface to hold camera / very steady hand

Collecte de données

Pour collecter vos données,

- Choisissez une scène intéressante à photographier. La scène devrait avoir une surface plane sur laquelle vous pourrez placer votre miroir sphérique. Elle peut être intérieure ou extérieure. Si vous êtes à l'extérieur, vous devriez vous placer à l'ombre, le soleil vous causera probablement des problèmes.

- Trouvez une place fixe et rigide pour placer votre caméra. Un trépied est idéal, mais vous pouvez aussi utiliser un objet stable.

- Placez votre miroir sphérique sur une surface plate et assurez-vous qu'il ne bouge pas. Soyez certain que la sphère ne soit pas trop éloignée de la caméra; elle devrait occuper au moins 256x256 pixels dans l'image.

- Photographiez le miroir sphérique en utilisant au moins trois différents temps d'expositions. Soyez certain que la caméra ne bouge pas trop (de très petite variation sont ok, mais le point de vue devrait être fixe). Pour de meilleurs résultats, vos temps d'expositions devraient être au moins 4 fois plus long et plus court (±2 stops) que votre temps d'exposition moyen (par exemple, si votre temps moyen est de 1/40s, alors vous devriez avoir des temps d'expositions d'au moins 1/10s et 1/160s). Notez les temps d'exposition, ou assurez-vous que votre caméra enregistre cette information dans l'en-tête EXIF du fichier image.

- Retirez le miroir de la scène et, du même point de vue que les autres photos, prenez une autre photo de la scène avec un temps d'exposition normal (la plupart des pixels sont ni trop ni pas assez exposés). C'est dans cette image que vous allez insérer des objets virtuels.

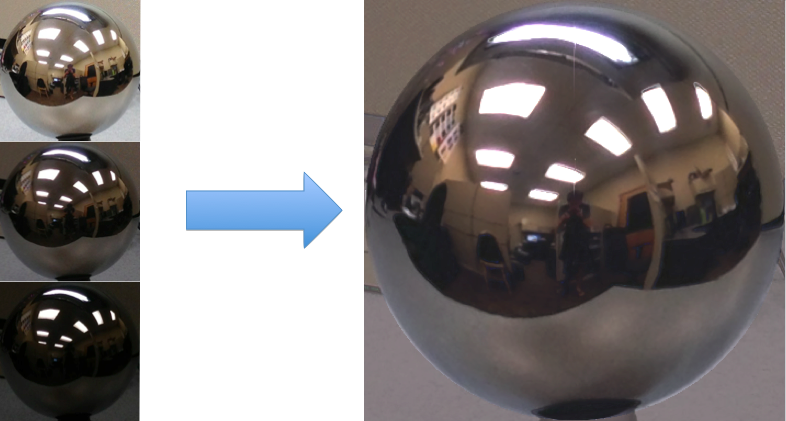

- Après avoir capturé les images, chargez-les dans votre ordinateur. Dans un éditeur d'image (ou dans Matlab), découpez l'image manuellement pour conserver uniquement la sphère (voir l'exemple plus bas).

- De petites erreurs d'alignement pourraient se produire (dues à un déplacement de la caméra, ou une erreur de découpage). S'il y a des différences substantielles avec la position/rotation de la caméra visible dans l'ensemble d'images, tentez d'aligner les images manuellement, ou recommencez à l'étape 4.

Data collection

To collect your data,

- Find a good scene to photograph. The scene should have a flat surface to place your spherical mirror on (see my example below). Either indoors or outdoors will work. If you go outdoors, we recommend shooting in the shade, as the sun may cause problems.

- Find a fixed, rigid spot to place your camera. A tripod is best, but you can get away with less. The back of a chair, a desk, a shelve, etc. should work well enough.

- Place your spherical mirror on a flat surface, and make sure it doesn't roll by placing a cloth/bottle cap/etc under it. Make sure the sphere is not too far away from the camera; it should occupy at least a 256x256 block of pixels.

- Photograph the spherical mirror using at least three different exposures. Make sure the camera does not move too much (slight variations are OK, but the viewpoint should generally be fixed). For best results, your exposures should be at least 4 times longer and 4 times shorter (±2 stops) than your mid-level exposure (e.g. if your mid-level exposure is 1/40s, then you should have at least exposures of 1/10s and 1/160s; the greater the range the better). Record the exposure times, or make sure they are available in the EXIF header of the image file.

- Remove the mirror from the scene, and from the same viewpoint as the other photographs, take another picture of the scene at a normal exposure level (most pixels are neither over- or under-exposed). This will be the image that you will use for object insertion/compositing (the "background" image).

- After you copy all of the images to your computer, load the spherical mirror images (from step 4) into your favorite image editor and crop them down to contain only the sphere (see example below).

- Small alignment errors may occur (due to camera motion or cropping). If there are substantial differences in camera position/rotation among the set of images, re-take the photographs.

2. Convertir les images capturées en une carte de radiance à haute plage dynamique

2. Converting these exposures into a single HDR radiance map

Cette étape vise à calculer une carte de radiance HDR (High Dynamic Range) à partir de plusieurs expositions LDR (Low Dynamic Range). Pour ce faire, nous utiliserons l'algorithme vu durant le cours, et décrit dans les sections 2.1 et 2.2 de Debevec et Malik 1997.

La valeur observée $Z_{i,j}$ d'un pixel $i$ dans une image $j$ est fonction de la radiance d'une scène $E_i$ (inconnue) et d'un temps d'exposition $\Delta t_j$ (connue):

\[ Z_{i,j} = f(E_i \times \Delta t_j) \,. \]Afin de rendre le problème linéaire, posons $g=\log f^{-1}$:

\[ g(Z_{i,j}) = \log(E_i) + \log(\Delta t_j) \,, \]voir l'équation 2 dans l'article de Debevec. Ces équations peuvent être écrites sous forme matricielle, et il est alors possible de résoudre à la fois pour $g(0), \ldots, g(255)$.

Afin de rendre les résultats encore plus robustes, il nous faudra deux détails supplémentaires:

- Afin d'enforcer la contrainte que $g$ soit lisse, il nous faudra minimiser la magnitude de la dérivée seconde de $g$. Puisque $g$ est une fonction discrétisée (définie uniquement sur des valeurs entières de $g(0)$ à $g(255)$, la dérivée seconde peut être approximée par: \[ g^{\prime\prime}(x) = (g(x-1) - g(x)) - (g(x) - g(x+1)) = g(x-1) + g(x+1) - 2g(x) \,. \] Ces équations doivent être écrites pour toutes les valeurs de $g(1)$ à $g(254)$, car pour $g(0)$ et $g(255)$ la dérivée seconde est indéfinie. Ces contraintes sont combinées aux équations précédentes avec un facteur $\lambda$, qui indique l'importance de minimiser la dérivée seconde.

- Chaque temps d'exposition nous donne uniquement de l'information fiable sur certains pixels (i.e. les pixels correctement exposés pour cette image). Pour les pixels sombres, la contribution relative du bruit est haute et, pour les pixels très clairs, le capteur aurait pu être saturé. Pour que nos estimations de $E_i$ soient plus précises, nous devons mesurer la contribution de chaque pixel selon l'équation 6 dans Debevec. Un exemple d'une fonction mesurant la contribution de chaque pixel $w$ est une fonction triangulaire avec une amplitude maximale à $Z=127.5$ et dont la valeur est zéro à $Z=0$ et $Z=255$. Cette pondération devrait être utilisée pour résoudre $g$ et lorsque vous utilisez $g$ pour créer la carte de radiance HDR pour tous les pixels.

We want to build an HDR radiance map from several LDR exposures. It is highly recommended that you read Sections 2.1 and 2.2 in Debevec and Malik 1997 to help understand this process. Below is a summary.

The observed pixel value $Z_{i,j}$ for pixel $i$ in image $j$ is a function of unknown scene radiance $E_i$ and known exposure duration $\Delta t_j$:

\[ Z_{i,j} = f(E_i \times \Delta t_j) \,. \]$E_i$ is the unknown scene radiance at pixel $i$, and scene radiance integrated over some time $E_i \times \Delta t_j$ is the exposure at a given pixel. We will not solve for $f$, but for $g=\log f^{-1}$ which maps from pixel values (from 0 to 255) to the log of exposure values:

\[ g(Z_{i,j}) = \log(E_i) + \log(t_j) \](equation 2 in Debevec). Solving for $g$ might seem impossible (and indeed, we only recover $g$ up to a scale factor) because we know neither $g$ nor $E_i$. The key observation is that the scene is static, and while we might not know the absolute value of $E_i$ at each pixel $i$, we do know that the value remains constant across the image sequence.

To make the results robust, we consider two additional things:

- We expect $g$ to be smooth. Debevec adds a constraint to our linear system which penalizes $g$ according to the magnitude of its second derivative. Since $g$ is discrete (defined only at integer values from $g(0)$ to $g(255)$ we can approximate the second derivative with finite differences: \[ g^{\prime\prime}(x) = (g(x-1) - g(x)) - (g(x) - g(x+1)) = g(x-1) + g(x+1) - 2g(x) \,. \] We will have one such equation for each integer in the domain of g, except for $g(0)$ and $g(255)$ where the second derivative would be undefined.

- Each exposure only gives us trustworthy information about certain pixels (i.e. the well exposed pixels for that image). For dark pixels the relative contribution of noise is high and for bright pixels the sensor may have been saturated. To make our estimates of $E_i$ more accurate we need to weight the contribution of each pixel according to Equation 6 in Debevec. An example of a weighting function $w$ is a triangle function that peaks at $Z=127.5$, and is zero at $Z=0$ and $Z=255$. This weighting should be used both when solving for $g$ and when using $g$ to build the HDR radiance map for all pixels.

3. Rendu d'objets synthétiques dans des photos

Dans cette dernière étape, nous utiliserons notre carte de radiance HDR comme source lumineuse pour effectuer de l'éclairage à base d'images et insérer des objets 3D dans la scène. Cela se divise en quatre étapes:

- L'estimation les paramètres de la caméra et le plan de la scène;

- L'ajoute d'objets à la scène;

- Le rendu;

- La composition dans l'image originale.

Téléchargez tout d'abord ce fichier qui contient du matériel (image, objets virtuels, etc.) et qui vous permettra de bien suivre les étapes expliquées ci-bas. Vous pouvez vous en servir comme point de départ, mais vous devrez ensuite remplacer l'image d'arrière-plan par vos propres photos!

Si vous êtes intéressés, vous trouverez plus de détails sur cette approche dans un autre article du même Debevec.

3. Rendering synthetic objects into photographs

In this last step, we will use our HDR radiance map as an image-based light and insert 3D objects into the scene. This consists of 4 main parts:

- Estimating the camera and ground plane parameters;

- Adding and matching HDR lighting and virtual objects to the scene;

- Rendering;

- Compositing into the original background image.

Download this file, which contains materials (image, virtual objects, etc.) that will allow you to follow the steps explained below. You can use it as a starting point, but you will eventually have to replace the background image with your own photos!

If interested, see additional details in this other Debevec paper.

Estimation de la caméra

Une fois que l'image HDR de l'environment est générée, la première étape à l'insertion d'objets est la modélisation d'une scène qui correspond à l'image d'arrière-plan. Cela peut être fait en identifiant un plan dans la scène d'arrière-plan, sur lequel nos objets virtuels seront placés, ainsi que la configuration de la caméra qui verrait le plan de cette perspective. Si vous êtes à l'aise avec la modélisation 3D avec Blender, vous pouvez modéliser manuellement la scène 3D et passer à la prochaine section.

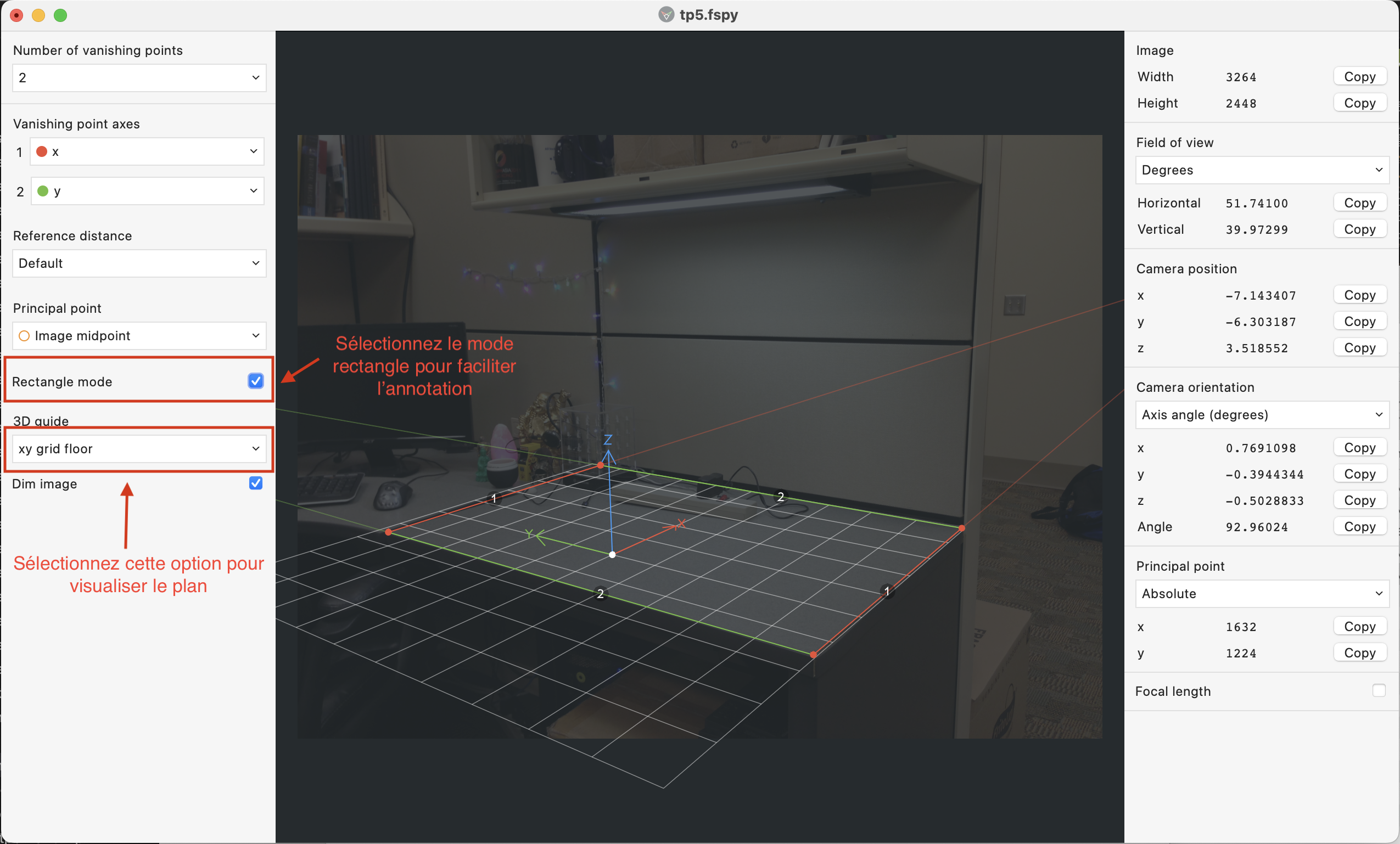

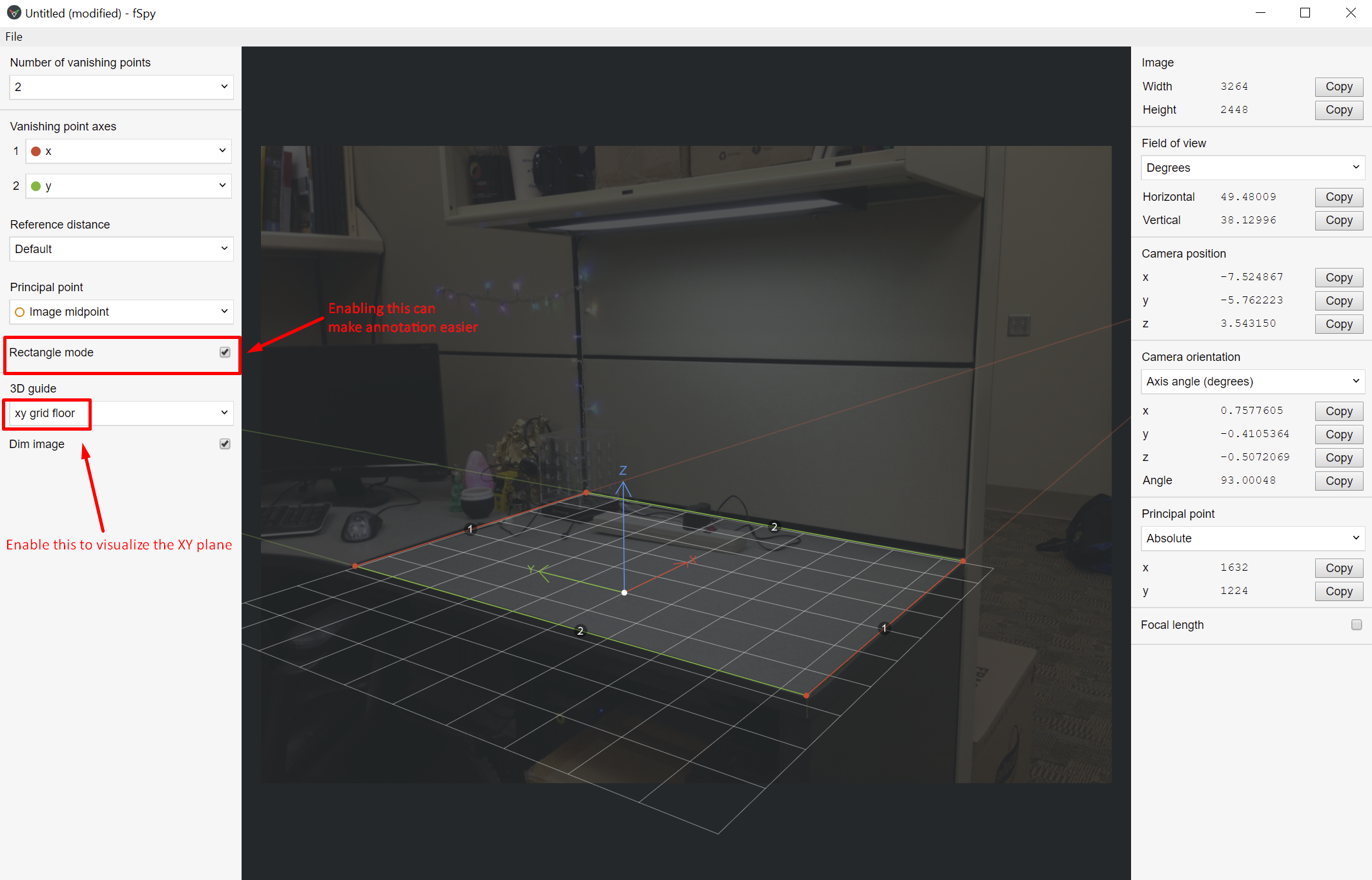

L'outil libre-accès fSpy permet d'obternir le plan et la caméra facilement. Après avoir installé le logiciel, ouvrez l'image d'arrière-plan avec l'option "File -> Open Image" dans le menu du haut. Le programme devrait ressembler à ceci:

Notre objectif est de positionner le plan XY pour correspondre avec l'image. Pour ce faire, déplacez les quatre coins du rectangle pour obtenir deux lignes orthogonales (formant un rectangle projeté) et positionnez le centre du plan en déplaçant le point blanc.

Pour avoir un ZOOM sur l'image en déplaçant les points, appuyez sur SHIFT.

Si vous connaissez la longueur focale de la caméra (ou si elle est disponible dans les metadata de l'image), vous pouvez la mentionner dans la section Focal length dans le menu de droite. Cela rendra l'approximation du logiciel plus robuste. Sinon, une valeur par défaut sera utilisée. La même chose s'applique au centre du plan image de la caméra, qui peut être mentionné dans la section Principal point ou laissé tel quel. En général, le placer au centre de l'image est une approximation suffisante (à moins que vous ayez la calibration des paramètres intrinsèques de votre caméra).

Le fonctionnement du logiciel fSpy est basé sur l'utilisation de lignes parallèles (définies manuellement par vous sur le plan XY) pour approximer l'horizon du monde et la ligne de fuite du plan XY. Si nous supposons que le plan XY est situé à l'origine 3D du monde sans rotation supplémentaire, nous pouvons interpréter la position de l'horizon comme une indication de la position de la caméra. Pour plus de détails sur l'obtention des paramètres de la caméra par géométrie projective, vous pouvez regarder le livre de Hartley et Zisserman.

Faites attention de sélectionner le plus grand rectangle que vous pouvez annoter avec confiance. Sinon, de petites différences de pixels introduisent de grandes différences dans les plans estimés (comme nous l'avons vu avec les homographies du TP4).

Lorsque vous êtes satifait du plan estimé, sélectionnez File -> Save As dans le menu du haut pour sauvegarder votre annotation. Assurez-vous d'utiliser l'extension .fspy dans le nom du fichier.

Camera Estimation

Once we have the HDR environment map, the first step to object insertion is constructing a local scene that matches our background image (see Figure 6 in Debevec's 1998 paper above for more details). This can be done efficiently by identifying a ground plane of the background scene, onto which our virtual objects will be placed, together with the camera configuration that would view the plane from that specific viewpoint. If you are comfortable with 3D modeling in Blender, feel free to skip to the next section and manually model the 3D scene, positioning the camera aligned with the background image.

Otherwise, we can obtain the ground plane and camera efficiently with the open-source tool fSpy. After unzipping the program in your desired location, go ahead and open the background image using the top bar's File -> Open Image menu. You should see something like this:

Our goal here is to position the XY plane such that the Z axis points up. To do this, drag the line vertices to orthogonal positions (forming a projected rectangle) and position the ground mesh (by draggin the white center). You can also not utilize Rectangle mode and set the Vanishing point axes in a different configuration, if that's easier for your image. Usually, though, rectangle mode is enough.

To zoom-in on the image when dragging the vertices, hold SHIFT.

If you know the focal length of your camera (or it is available in the image's metadata), you can set it on the Focal length portion of the right-hand side. This will make your approximation more robust. Otherwise, a generic value will be used. The same applies to the camera's image plane center, which you can adjust manually using the Principal point setting or leave it as-is. Usually, setting it to the image's midpoint is a good-enough approximation (unless you have already calibrated your camera's intrinsic parameters).

The whole concept behind fSpy is to utilize parallel lines (manually set by you on top of the ground plane) to approximate the world's horizon, or, in other words, the ground plane's vanishing line. If we assume the ground plane is located at the world's 3D origin with no additional rotation, we can instead interpret the position of the horizon to be an indication of the camera's position. For more details on obtaining camera parameters through projective geometry, check out Hartley and Zisserman's seminal book.

Make sure to provide the largest rectangle you can confidently annotate. Otherwise, small pixel differences may provide very degenerated planes (as we saw in the homographies of TP4).

Once you're happy with your plane, select the topbar's File -> Save As to store your annotation. Make sure to

utilize the .fspy extension in the filename.

Blender

Pour effectuer le rendu des objets virtuels, nous utiliserons le logiciel libre Blender.

- Tout d'abord, téléchargez et installez la dernière version de Blender (v4.4).

- Ensuite, téléchargez le fichier suivant, qui contient la scène

ibl.blendet ouvrez-la avec blender. Cette scène,ibl.blend, est celle qui a été utilisée pour créer le résultat dans le haut de la page. Dans le cadre de ce TP, nous vous conseillons de l'utiliser comme point de départ et de le modifier pour vos propres images et objets. - Également, téléchargez le plug-in fSpy pour Blender ici. Les instructions d'installations sont disponibles sur le README du répertoire.

Le tutoriel suivant pourrait vous être utile pour vous familiariser avec l'interface graphique de Blender:

Blender

To perform virtual object insertion, we will be using the open source software Blender.

- First, download and install Blender's most recent version (v4.4).

- Next, download this file, which contains the

ibl.blendscene and open it with Blender. This scene,ibl.blend, was used to create the result shown above. For this homework, we recommend you use it as strating point and modify it to add your own images and virtual objects. - In addition, also download the Blender fSpy plugin here.

Installation instructions are available in the README file.

The following tutorial will help you get familiarized with the Blender GUI:

Modélisation de la scène

Les instructions ci-dessous supposent que vous modifierez le fichier fourni pour créer votre propre résultat composite, mais n'hésitez pas à créer votre propre fichier si vous êtes à l'aise avec Blender.

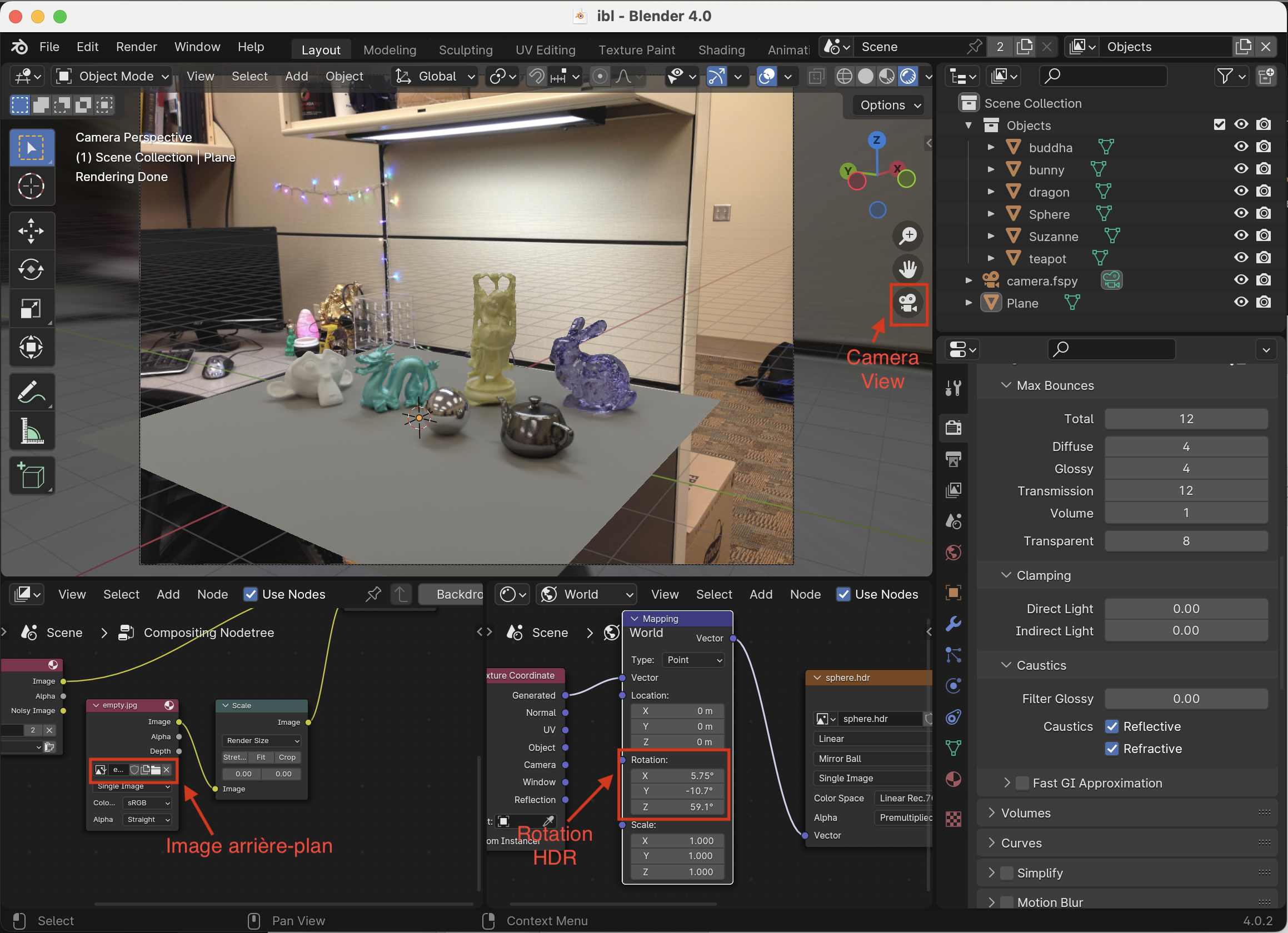

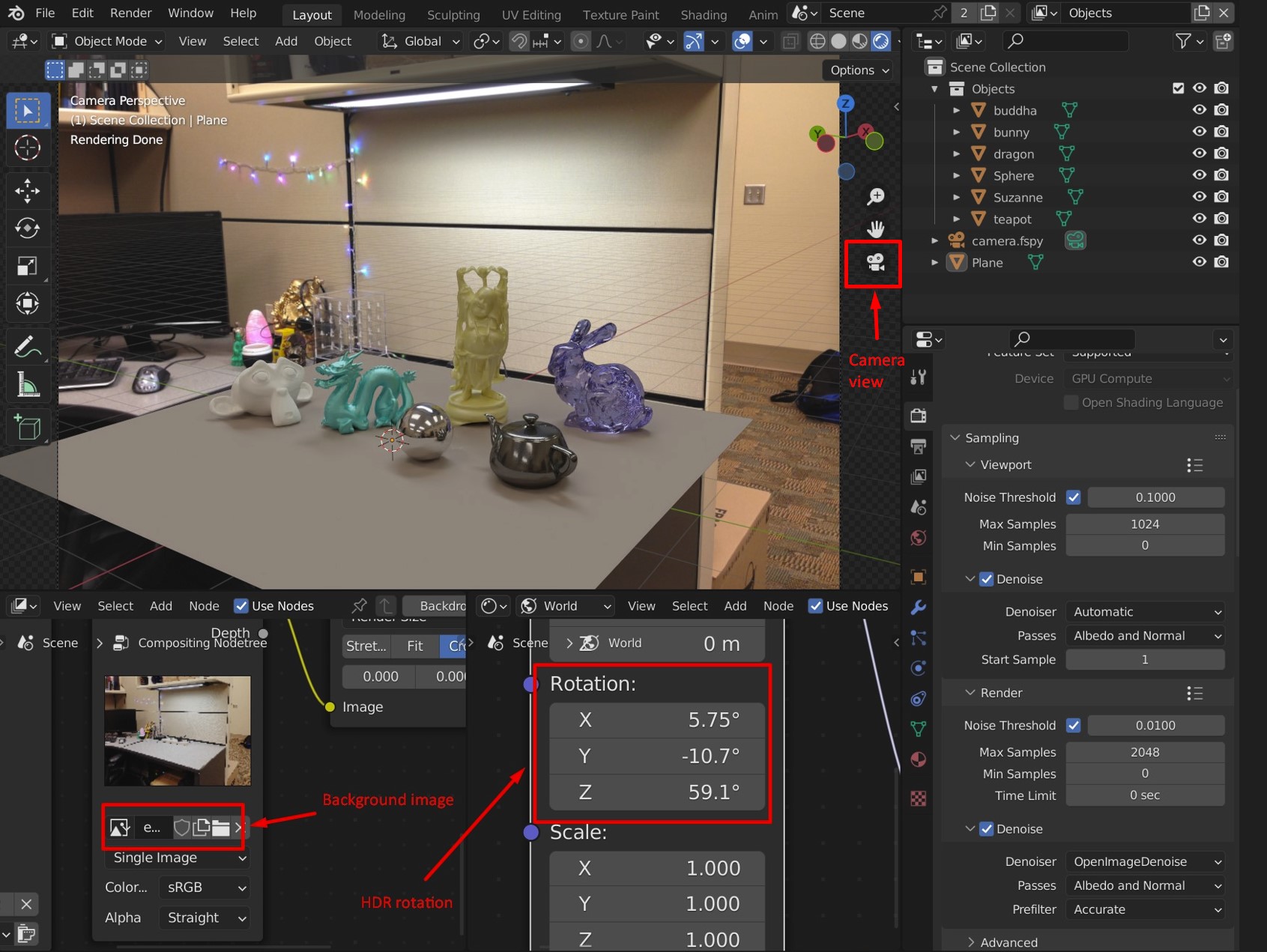

Une fois le fichier ibl.blend ouvert, vous devriez voir une interface similaire à celle-ci:

Voici une brève description de chacune des sections:

- Vue 3D: Spécifie la géométrie de la scène virtuelle.

- Vue d'ensemble: Permet de spécifier les propriétés de chaque objet dans la scène.

- Éditeur de composition: Spécifie chacune des images qui doivent être rendues.

- Éditeur de shader "Monde": Spécifie l'apparence de l'environment.

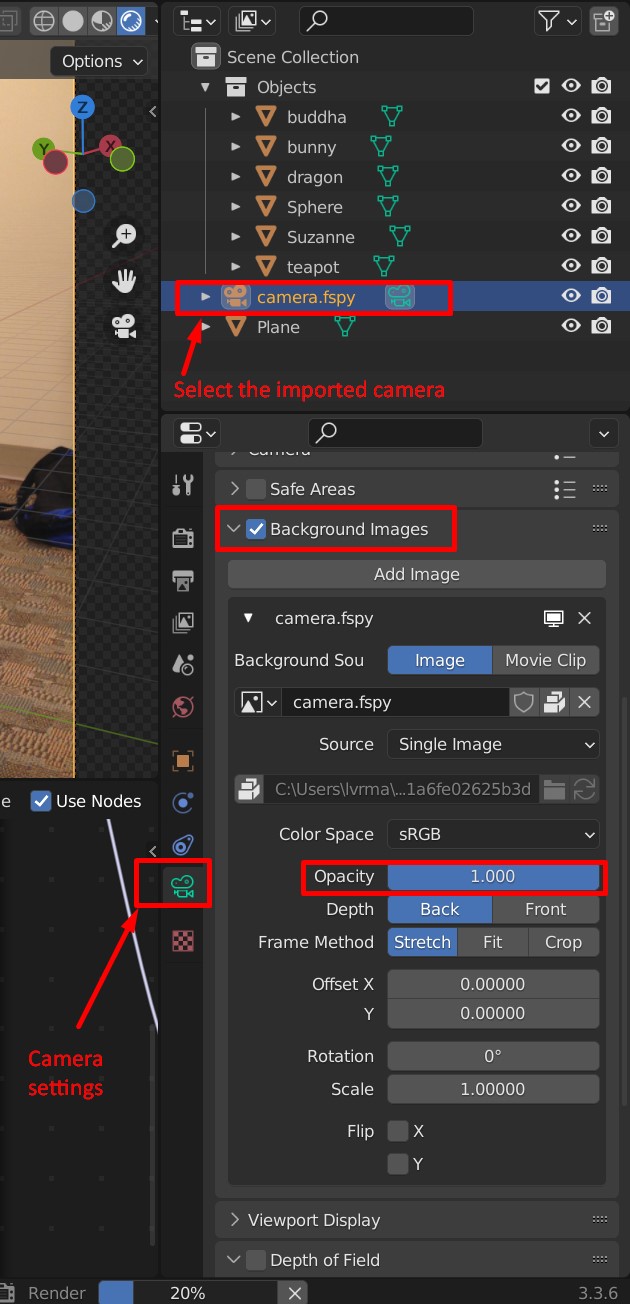

Pour importer la caméra fSpy, allez dans le menu du haut File -> Import -> fSpy. Assurez-vous de supprimer la caméra existante avant d'ajoutez la vôtre. Pour voir la scène de la perspective de la caméra, cliquez sur l'icone camera view.

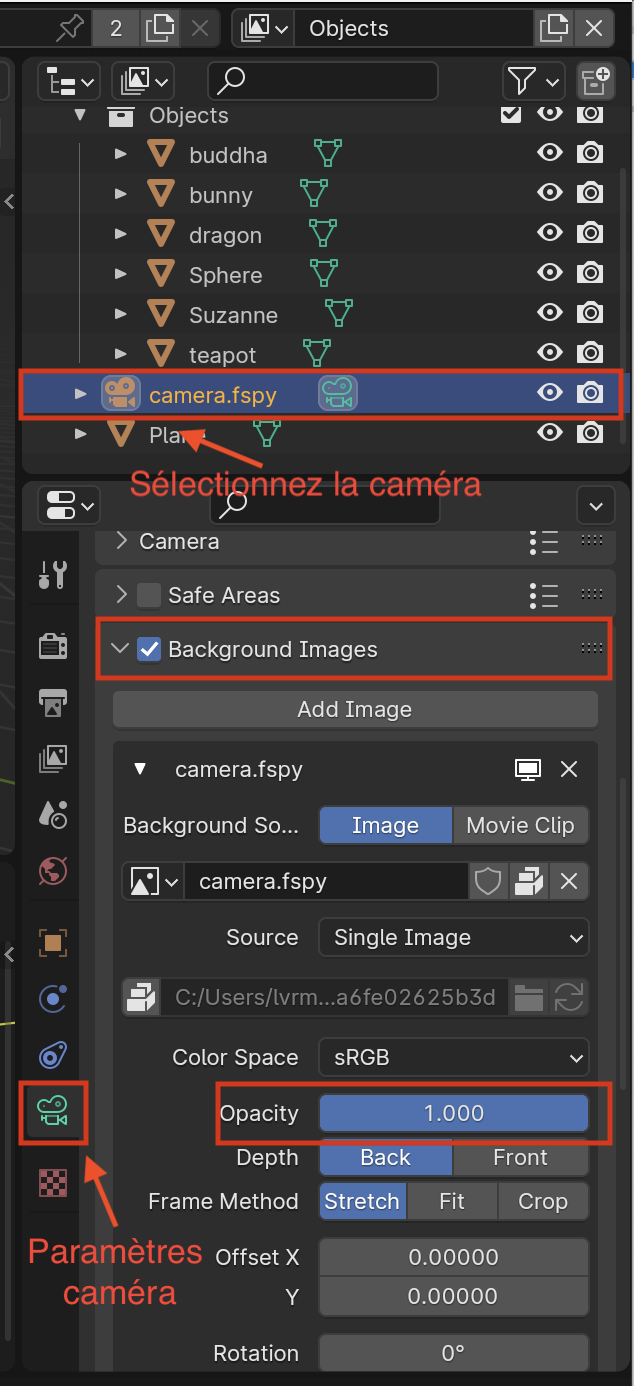

Importez également l'image d'arrière-plan dans le compositeur (voir l'image ci-dessus). Il est possible que l'arrirère-plan soit légèrement transparent dans la vue 3D:

Pour régler l'opacité de l'arrière-plan, sélectionnez la caméra fSpy, puis allez dans les paramètres de la caméra (voir l'image ci-dessus), cherchez la section Background images et ajustez le curseur Opacity à 100%.

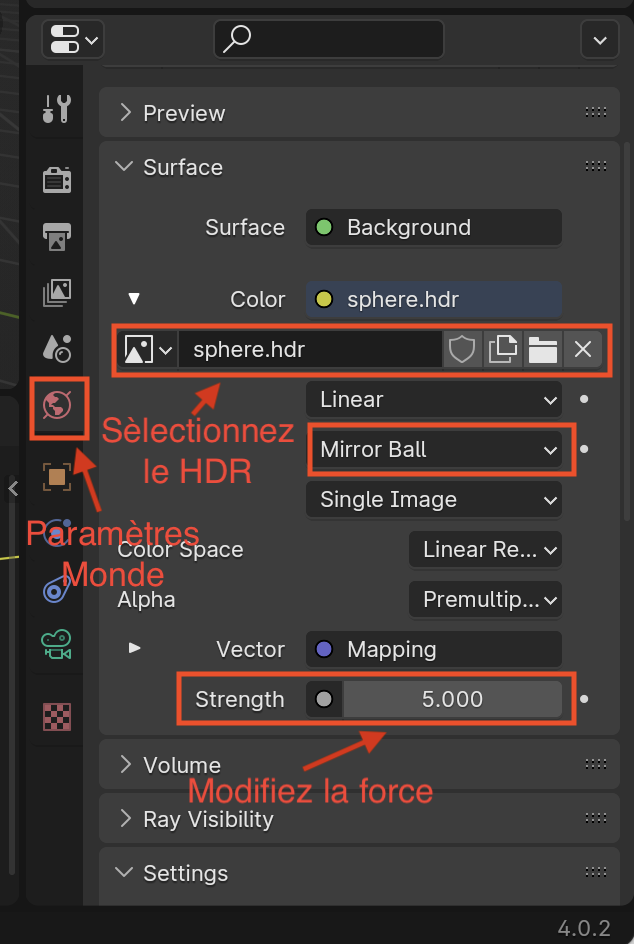

Ensuite, ajouter l'éclairage HDR. Pour ce faire, allez dans les paramètres du monde comme suit:

Assurez-vous que l'option Mirror Ball est activée. Suivez les instructions de l'image pour sélectionner votre fichier HDR, puis ajustez la force si la lumière est trop forte ou trop faible. Il peut également être nécessaire de tourner votre image HDR autour de l'origine en utilisant les options indiqués sur la première image ci-dessus. Un bon truc est d'utiliser une sphère miroir dans votre scène, comme celle du fichier fourni, et d'ajuster la rotation de votre image HDR en fonction de ses réflexions pour qu'elle corresponde à la photo. Un autre guide utile est la direction des ombres.

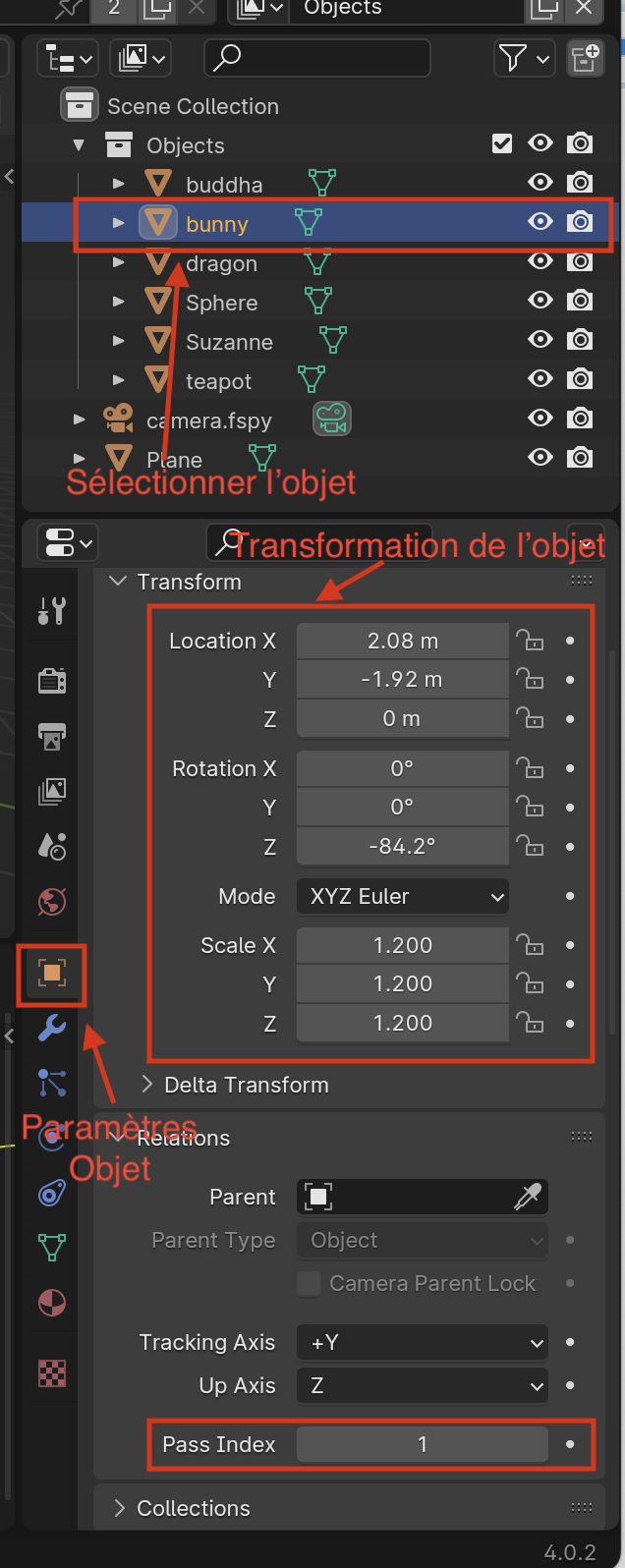

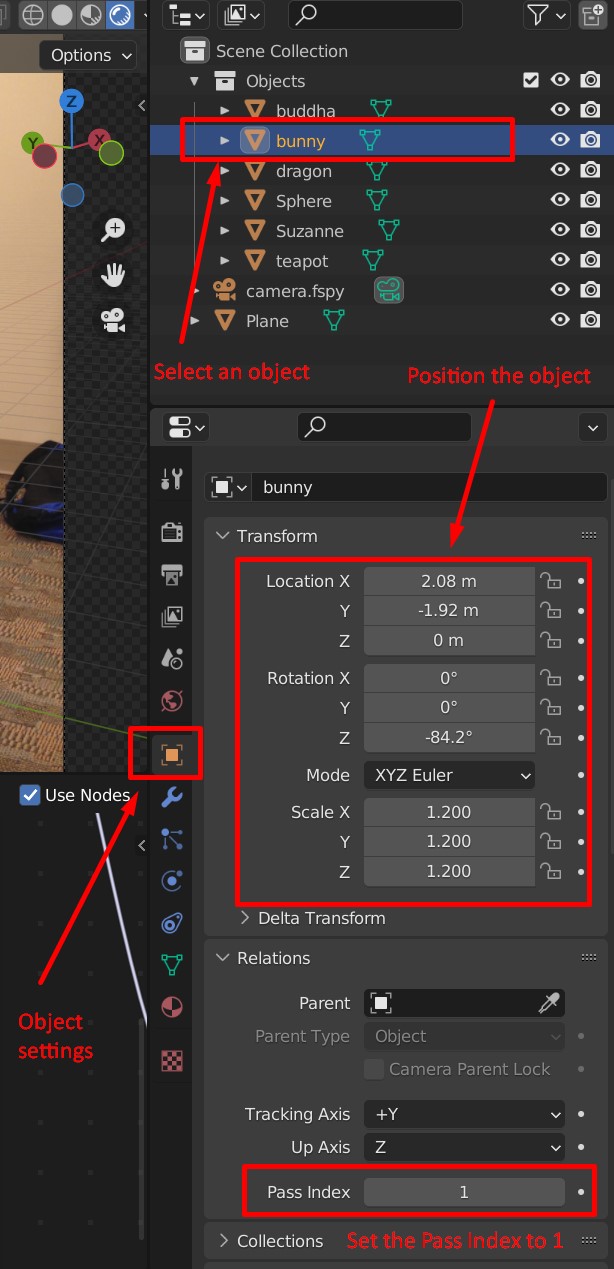

Il est maintenant temps d'ajouter vos objets! Ils peuvent être importés dans le menu File -> Import et apparaîtront dans la vue d'ensemble. Après avoir ajouté un objet, vous devez ajuster son échelle, sa translation et sa rotation pour qu'il soit bien placé sur le plan de la scène:

Il est aussi très important de changer le Pass Index de chaque nouvel objet à 1, comme indiqué ci-dessus sinon ils n'apparaîtront pas dans le masque binaire du compositeur.

Un bon truc pour positionner vos objets est de sélectionner l'objet Plane, d'aller dans ses paramètres comme indiqué ci-dessus, puis de chercher la section Visibility. Activez l'option Shadow Catcher. Ensuite, allez dans les Render Properties (icône de caméra grise, au-dessus des paramètres du monde dans le menu des propriétés). Là, cherchez Film et sélectionnez Transparent. Cela rendra votre plan transparent mais les ombres et les reflets des objets resteront visibles, vous donnant un aperçu de ce que la composition pourrait ressembler. N'oubliez pas de désactiver le shadow catcher lorsque vous avez terminé de positionner vos objets, sinon l'équation de Debevec ne fonctionnera pas! N'oubliez pas non plus de désactiver le film transparent, sinon vous aurez des problèmes de mélange alpha dans vos compositions.

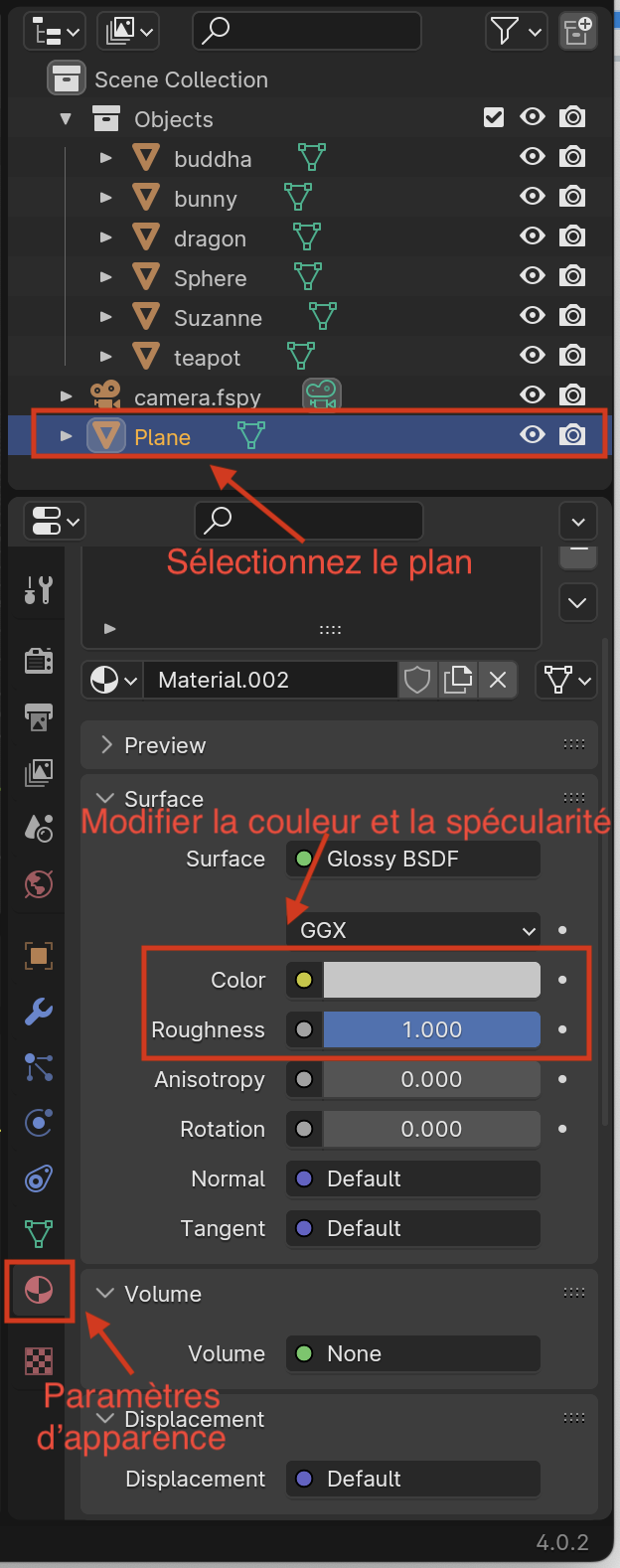

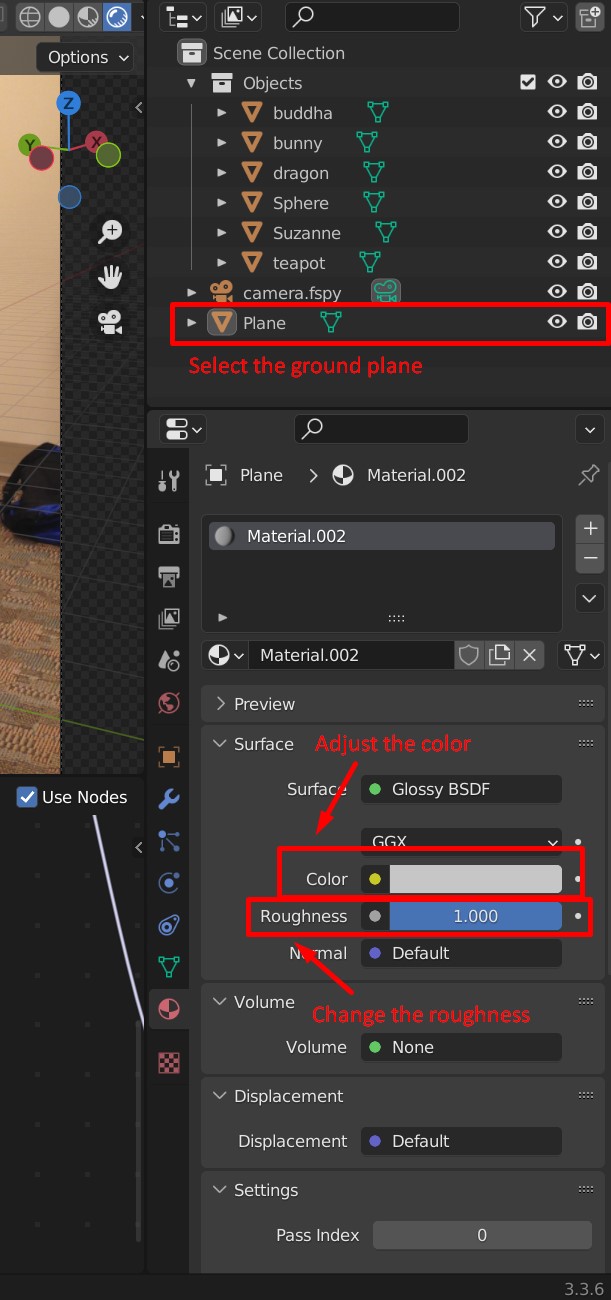

Finalement, vous devez changer l'apparence de votre plan (très important pour les objets réfléchissants) pour qu'elle corresponde à l'image d'arrière-plan. Vous devez changer sa couleur et sa spécularité (i.e., à quel point la surface du plan doit être "brillante" et réfléchissante). Cela peut être fait en utilisant le slider de roughness, comme indiqué ci-dessous:

La fonction Shadow Catcher est également très utile ici, pour s'assurer que les réflexions correspondent à la surface du matériau de l'arrière-plan (par exemple, un sol en béton ne devrait pas réfléchir comme une table en bois poli).

Modeling the local scene

Open the provided ibl.blend file.

This is the blend file used to create the result at the top of the page.

The instructions below assume you will modify this file to create your own composite result,

but feel free to create your own blend file from scratch if you are comfortable with Blender.

At first glance, the Blender scene should look something like this:

Clockwise from the top-left, we have 6 main views: the viewport, outliner, properties, world shader editor, and compositor (for render passes). We'll go through them in a bit more detail soon.

Assuming you have the fSpy plug-in installed, the camera can be imported through the top bar's File -> Import -> fSpy. Make sure to delete the existing camera when you add yours. To view the scene from the camera's viewpoint, click on the camera view icon above. Now is also a good time to import the background image in the compositor (see the image above).

You may notice the background image in the viewport is slightly transparent:

To fix this, select your fSpy camera, then go to the camera settings (see the image above), look for the Background images section and set the Opacity slider to 100%.

Next, you need to add your HDR lighting. To do this, go to the world settings as follows:

Make sure the option Mirror Ball is enabled. Following the image's directions, select your HDR file, then adjust the strength in case the light is too strong or weak. It might also be necessary to rotate your HDR image around the origin using the sliders indicated on the first Blender image above. A good trick is to utilize a mirror sphere in your scene, like the one in the provided file, and adjust your HDR rotation by the reflections on it, as seen from the camera's viewpoint. Another useful guideline is the direction of the cast shadows: do they look coherent?

Next, you need to add your own objects. Meshes can be imported on the same File -> Import menu and will appear listed on the outliner. After adding an object, you must adjust its scale, translation, and rotation, so it looks right on top of the ground plane:

It is also very important to remember to change the Pass Index of every new object to 1, as indicated above, otherwise they won't show up in the compositor's binary mask.

A good tip to help positioning your objects is to select the Plane object, go to its settings like shown above, then look for the Visibility section. There, enable Shadow Catcher. Then, go to the Render Properties (gray camera icon, above the world settings on the properties menu). There, look for Film and select Transparent. This will make your plane transparent but the object shadows and highlights will remain visible, giving you a preview of what the composition would look like. Remember to disable the shadow catcher when you are done positioning your objects, though, otherwise Debevec's equation won't work! Also remember to disable the transparent film, otherwise you will get alpha blending issues in your compositions.

Finally, you need to change the color of your plane (very important for reflective objects) to match the background image. You also need to change how specular the plane surface should be (i.e., how "shiny" and reflective it should be). This can be done using the roughness slider, as shown below:

The shadow catcher feature is also very useful here, to make sure the reflections match the surface material in the background (e.g., a concrete floor should not reflect like a polished wooden table).

Rendu

Une fois que vous êtes satisfait de votre scène, allez dans la barre du haut et sélectionnez Render -> Render Image. Lorsque le rendu sera terminé (cela peut prendre un certain temps, selon la résolution de votre image), les quatre images nécessaires pour la composition seront sauvegardées dans le même dossier que votre fichier Blender.

Rendering

Once you're happy with your scene, go to the top bar and select Render -> Render Image. After the rendering is done (can take a while, depending on the resolution of your image) the four images needed for composition will be saved in the same folder as your blend file.

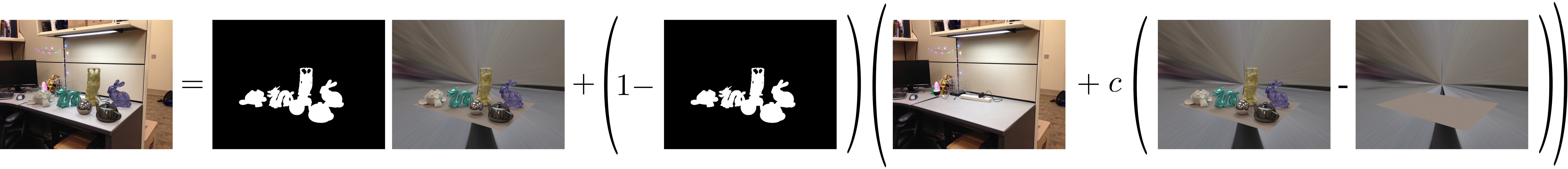

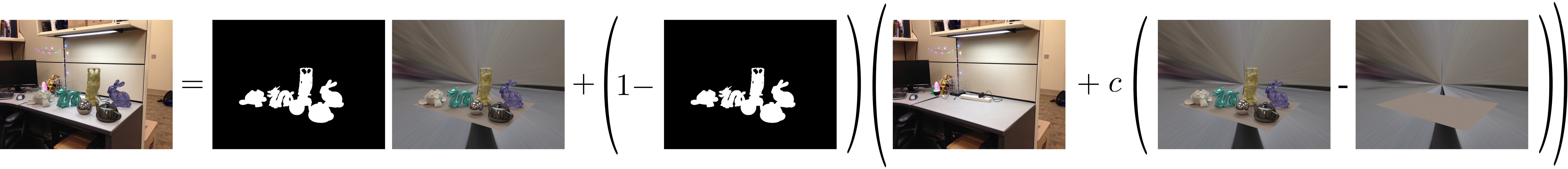

Composition

Pour compléter l'insertion d'objets, nous allons utiliser les trois images rendues précédemment pour effectuer une composition par "rendu différentiel". Cela peut être fait par une simple équation à appliquer pour chaque pixel. Si $R$ est l'image rendue avec les objets, $E$ l'image rendue sans les objets, $M$ le masque des objets et $I$ l'image d'arrière-plan, la composition finale $C$ est calculée avec:

\[ C = M R + (1-M)(I + c(R-E)) \,. \]

Cette équation est décrite dans la section 6 de l'article de Debevec 1998. Les deux premiers termes copient les objets insérés dans l'image d'arrière-plan et le troisième terme, modulé par $c$, ajoute les effets d'illumination des objets insérés (ombres, caustiques, les inter-réflexions, etc.). Fixez $c=1$ initialement, mais ensuite essayez différentes valeurs pour obtenir des ombres et inter-réflexion plus sombres ou plus claires. Vous pouvez implémenter cette étape en python.

Compositing

To finish the insertion, we will use the above rendered images to perform "differential render" compositing. This can be done using a simple pixel-wise equation. Let $R$ be the rendered image with objects, $E$ be the rendered image without objects, $M$ be the object mask, and $I$ be the background image. The final composite is computed with:

\[ C = M R + (1-M)(I + c(R-E)) \,. \]

This equation is described in sec. 6 of the 1998 Debevec paper. The first two terms effectively paste the inserted objects into the background image, and the third term adds the lighting effects of the inserted objects (shadows, caustics, interreflected light, etc), modulated by $c$. Set $c=1$ initially, but try different values to get darker or lighter shadows/interreflections. You can implement this step in python. An example of a final compositing result achieved using this is at the top of the page.

Conseils

Quelques conseils pour calculer $g$:

- N'utilisez pas tous les pixels disponibles autrement vous allez probablement manquer de mémoire ou bien avoir un temps d'exécution horriblement long. À la place, échantillonnez aléatoirement un ensemble de pixels (environ une centaine devrait suffire), mais assurez-vous que les pixels soient les mêmes pour toutes les images.

- Utilisez l'équation 4 de l'article (i.e.

w = lambda z: 128.0-np.abs(z-128.0)) pour calculer $w$. - Essayez différentes valeurs de $\lambda$ pour retrouver $g$. Initialement, essayez $\lambda=1$, résolvez $g$ et affichez-la. La fonction devrait être lisse et augmenter continuellement. Si $\lambda$ est trop petit, $g$ sera bosselée.

- Référez-vous à l'équation 6 dans l'article de 1997 pour utiliser $g$ et combiner toutes vos expositions dans une image finale. Notez que cela produit les valeurs log de la radiance, donc assurez-vous de calculer l'exponentielle du résultat et de sauvegarder la radiance absolue.

- Vous pouvez sauvegarder les fichiers HDR en utilisant la fonction

imwrited'OpenCV.

Quelques conseils sur Blender:

- Sauvegardez vos fichiers régulièrement!

- Pour déplacer plus qu'un objet à la fois, sélectionnez plusieurs objets en utilisant la touche shift. Appuyez sur 'a' pour désélectionner tous les objects/vertex.

- Vous pouvez modifier les vertex directement en "Edit mode" (la touche tab change entre le "Object mode" et le "Edit mode").

- En raison de la convention, la caméra doit toujours être pointée de telle sorte que l'axe +z soit vers le haut, assurez-vous de vérifier votre aperçu fSpy!

Tips

Some hints on solving for $g$:

- When providing input, don't use all available pixels, otherwise you will likely run out of memory / have very slow run times. To overcome this problem, just randomly sample a set of pixels (100 or so can suffice), but make sure all pixels are the same for each exposure.

- The weighting function $w$ should be implemented using Eq. 4 from the paper (i.e.

w = lambda z: 128.0-np.abs(z-128.0)). - Try different $lambda$ values for recovering $g$. Try $lambda=1$ initially, then solve for $g$ and plot it. It should be smooth and continuously increasing. If $lambda$ is too small, $g$ will be bumpy.

- Refer to Eq. 6 in the 1997 paper for using $g$ and combining all of your exposures into a final image. Note that this produces log radiance values, so make sure to exponentiate the result and save absolute radiance.

- You can save HDR files using OpenCV's

imwritefunction.

Some tips on using Blender:

- Save your Blender file regularly!

- To move more than one object at once, select multiple objects using shift. Pressing 'a' deselects all objects/vertices.

- You can edit vertices directly in "Edit mode" (tab toggles between Object and Edit modes).

- Due to convention, the camera should always be pointed such that the +z axis is up, make sure to check your fSpy preview!

Crédits supplémentaires

Essayez une de ces idées pour approfondir vos connaissances (et augmenter votre note):

- (10 points) Implémentez une fonction de conversion entre l'image de la sphère et une représentation en "latitude-longitude" de votre carte d'environnement. Rappel: la représentation "latitude-longitude" est une image de résolution N lignes x 2N colonnes, où les lignes représentent l'élévation (de haut en bas, de $\pi/2$ à $-\pi/2$), et les colonnes l'azimuth (de gauche à droite de $-\pi$ à $\pi$). Affichez les cartes d'environnement de vos deux scènes avec cette nouvelle représentation.

- (5 points par scène, max 20 points) Insérez des objets virtuels dans plus de 2 scènes! Vos nouvelles scènes doivent être décrites dans le rapport de la même manière que vos scènes obligatoires (voir "Évaluation" ci-dessous). Ces nouvelles scènes ne peuvent pas contenir les objets du fichier .blend d'exemple.

- (20 points) Reproduction tonale locale. Les images HDR peuvent également être utilisées pour créer des images hyper-réaliste avec un contraste amélioré. Cet article de Durand et Dorsey décrit une technique simple pour augmenter le contraste des images en utilisant un opérateur de reproduction tonale locale qui comprime efficacement la gamme dynamique de la photo dans un format visualisable tout en préservant les détails et le contraste. Implémentez la méthode présentée dans l'article et comparez vos résultats à d'autres opérateurs de reproduction tonale, par exemple celui de Reinhard vu dans le cours (15 points pour la méthode de Durand et ses résultats, 5 points pour la comparaison). Vous n'avez pas à implémenter le filtre bilatéral vous-même, vous pouvez utiliser

skimage.restoration.denoise_bilateral. Vous trouverez quelques exemples d'images HDR ici. - (10 points par scène, maximum 20 points) Adaptez l'éclairage à l'emplacement dans la scène. L'éclairage capturé par la sphère n'est valide qu'à l'endroit où la sphère est placée dans la scène. Donc, si on voulait placer plusieurs objets dans la scène, il faudrait idéalement capturer des sphères métalliques à tous ces endroits. Pour ces crédits supplémentaires, vous pouvez utiliser l'une des scènes qui ont déjà été capturées en HDR pour vous parmi les scènes de ce jeu de données. Insérez des objets différents aux endroits correspondants à chacune des sphères métalliques. Illustrez vos résultats, et comparez à ce que vous obtenez si vous illuminez tous les objets avec la même source lumineuse (par exemple, une des sphères située près du centre de l'image).

- (10 points) Faites une composition HDR linéaire complète! Capturez votre image d'arrière-plan en HDR, changez la sortie de Blender en HDR, composez en espace linéaire, puis tonemappez pour l'affichage.

- (10 points) Faites une animation vidéo.

- (20 points) Calibrez les paramètres intrinsèques de votre caméra, la fonction de réponse et la réflectivité de votre sphère avant de capturer la scène HDR. Comparez vos cartes de radiance obtenues et vos compositions avec et sans les vraies données.

- (10 points) Capturez une scène à l'extérieur, avec le soleil visible, et proposez un algorithme pour obtenir les coordonnées sphériques du soleil en utilisant seulement les valeurs HDR dans votre sphère.

Bells and Whistles

Try one of these ideas to increase your understanding on this subject (and increase your score):

- (10 points) For 10 points, implement a conversion function between the mirror ball image and a "latitude-longitude" representation of your environment map. Reminder: the "latitude-longitude" representation is an image of resolution N rows x 2N columns, where the rows represent elevation (top to bottom, from $\pi/2$ to $-\pi/2$), and the columns azimuth (left to right from $-\pi$ to $\pi$). Display the environment maps of your two scenes with this new representation.

- (5 points per scene, max 20 points) Insert virtual objects into more than 2 scenes! To count, your new scenes must be described in the same way as your mandatory scenes (see "Evaluation" below). These new scenes may not contain the objects in the example .blend file.

- (up to 20 points) Local tonemapping operator. HDR images can also be used to create hyper-realistic and contrast enhanced LDR images. This paper describes a simple technique for increasing the contrast of images by using a local tonemapping operator, which effectively compresses the photo's dynamic range into a displayable format while still preserving detail and contrast. Implement the method found in the paper and compare your results to other tonemapping operations. You can use this bilateral filter code in your implementation. You can find some example HDR images here.

- (10 points per scene, maximum 20 points) Adapt the lighting to the location in the scene. The lighting captured by the sphere is only valid where the sphere is placed in the scene. So, if you wanted to place multiple objects in the scene, you would ideally capture metal spheres at all these locations. For these extra credits, you can use one of the scenes that have already been captured in HDR for you amongst the scenes in this dataset. Insert different objects at the locations corresponding to each of the metal spheres. Illustrate your results, and compare to what you get if you illuminate all objects with the same light source (for example, one of the spheres located near the center of the image).

- (up to 10 points) Make a full linear HDR composition! Capture your background image in HDR, change Blender's output to HDR, compose in linear space, then tonemap for display.

- (up to 10 points) Make a video animation.

- (up to 20 points) Calibrate you camera's intrinsic parameters, response function, and you sphere's reflectivity before capturing the HDR scene. Compare your obtained radiance maps and your compositions with and without the real data.

- (up to 10 points) Capture a scene outdoors, with the sun visible, and propose an algorithm to get the sun's spherical coordinates just using the HDR values in your reflective probe.

Livrables

Comme lors des travaux précédents, celui-ci sera remis dans un format page Web. Rappel: le site Web n'a pas besoin d'être esthétiquement agréable; ne faites que décrire ce que vous avez fait.

Plus précisément, la page devrait contenir:

- (70% pour 4105, 60% pour 7105) Rendu d'objets synthétiques dans deux de vos propres photos :

- Votre premier résultat peut contenir les mêmes objets que la scène

ibl.blendfournie en exemple. - La second résultat doit contenir des objets différents, avec des propriétés différentes. Soyez créatifs! Pour cela, vous pouvez choisir parmi les options gratuites dans des sites web tel que: Turbosquid, Free3D, CGTrader, etc. Assurez-vous de bien citer vos sources.

- Comme vous devez partager les sphères métalliques en équipes, les mêmes images peuvent être partagées parmi les membres de l'équipe. Mentionnez les membres de l'équipe dans votre rapport.

- Vous devez tout de même remettre un rapport individuel.

- Votre premier résultat peut contenir les mêmes objets que la scène

- (30% pour 4105, 20% pour 7105) Pour une des scènes que vous aurez sélectionnée, présentez et décrivez brièvement tous les résultats intermédiaires nécessaires au calcul de la radiance :

- Affichez les photos capturées;

- La fonction $g$ estimée, discutez de l'influence du facteur $\lambda$;

- La carte de radiance obtenue en log (vous pouvez utiliser le log du canal G de l'image obtenue);

- La carte de radiance obtenue en RGB. Pour ce faire, utilisez un « gamma », par exemple, $\gamma=2.4$ ($x^{1/2.4}$ où $x$ est un pixel).

- (N%) Expliquer les crédits supplémentaires que vous avez implémentés. Illustrez ces explications. De plus, si cela s'applique, montrez correctement le « avant » et le « après » et démontrez l'avantage de l'approche que vous aurez essayée.

Idées pour les discussions

L'objectif des discussions dans vos rapports est que vous nous fassiez part de vos réflexions sur vos résultats. Tentez d'être précis(es) dans vos descriptions. Voici quelques idées :

- Commentez sur la qualité des résultats. Sont-ils à la hauteur de vos attentes? Voit-on clairement l'effet de l'éclairage? Avez-vous tenté de modifier la valeur de $c$ dans l'équation de composition différentielle?

- Quand ça fonctionne, commentez tout de même sur ce qui fait que ça fonctionne.

- Si vous avez rencontré des problèmes sur certaines scènes, décrivez ces problèmes et expliquez comment vous avez tenté de les résoudre. Tentez d'expliquer pourquoi ça fonctionne mieux sur certaines scènes plutôt que d'autres.

- Si vos algorithmes échouent sur certaines images, décrivez les problèmes et expliquez pourquoi ils surviennent selon vous;

- Décrivez, le cas échéant, les ajustements que vous avez apportés à l'approche proposée.

Deliverables

As in the previous homework, this one will be handed in a webpage format. Remember: the aesthetics of the website will not be evaluated, but it is important that the information be presented clearly.

More precisely, the webpage should:

- (70% for 4105, 60% for 7105) Rendering synthetic objects into two of your own photographs:

- Your first photo can contain the same objects as the

ibl.blendscene we we gave you as an example. - Your second photo must contain different objects, with different material properties. Be creative! For this, you can browse free online 3D model repositories such as: Turbosquid, Free3D, CGTrader, etc. Make sure you give credit if you use any of these models.

- Since you must share the chrome spheres, the same images can be used by the different team members. Make sure you indicate the team member's names in your report.

- You must still hand in an individual report.

- Your first photo can contain the same objects as the

- (30% for 4105, 20% for 7105) For one of the scenes, present and describe all the results of the steps to compute the radiance:

- Display the captured photos;

- The estimated $g$ function, discuss the influence of the $\lambda$ factor;

- The radiance map obtained in log (you can use the log of the G channel of the image obtained);

- The radiance map obtained in RGB. To do this, use a "gamma", for example, $\gamma=2.4$ ($x^{1/2.4}$ where $x$ is a pixel).

- (N pts) for any bells and/or whistles you've added in. Reminder: graduate students must add to their assignment at least 20 pts worth of bells and whistles.

Discussion Ideas

The objectif of the discussions in your reports is to share your reflections on your results. Try to be precise in your descriptions. Here are some ideas:

- Comment on the quality of the results. Are they up to your expectations? Can you clearly see the effect of the lighting? Have you tried to modify the value of $c$ in the differential composition equation?

- When it works as expected, comment on what makes it work.

- If you encountered problems on some scenes, describe these problems and explain how you tried to solve them. Try to explain why it works better on some images than others.

- If your algorithms fail on some images, describe the problems and explain why they occur;

- Explains, if applicable, the adjustments you have made to the proposed approach.

Remise

Pour la remise de votre travail, créez un fichier tp5.zip qui contient:

- Votre rapport en format HTML dans un dossier

tp5/web. Vos images doivent être dans un dossiertp5/web/images. - Votre page principale doit être

tp5/web/index.html. De plus, assurez-vous qu'il n'y a aucun caractère spécial (accent, ponctuation, espace, etc.) dans les noms de vos fichiers, images, etc. - Votre code doit être dans un dossier

tp5/code. N'incluez pas les images que vous avez utilisées pour produire vos résultats dans ce dossier dans le but de ne pas alourdir le fichier.

Finalement, veuillez téléverser votre fichier tp5.zip sur le portail des cours avant la date limite. La politique des retards mentionnée dans le plan de cours sera appliquée. Pour toutes questions concernant la procédure de remise ou le travail lui-même, posez vos questions sur PAX!

Handing in procedure

For this homework, you must create a tp5.zip file. In this file you'll put:

- Your report in an HTML format inside a folder named

tp5/web. Your images for this web page should be inside a folder namedtp5/web/images. - Your main page has to be

tp5/web/index.html. Make sure none of the files have special characters (e.g. accents, punctuation, spaces, etc.) in their filenames. - Your code should be put inside the folder

tp5/code. Do not include the images you have used to generate your results inside this folder, as this will likely generate huge files.

Finally, you should upload this file (tp5.zip) on the "portail des cours" before the deadline. The late submission policy described in the course plan will be applied. For any question regarding the submission process or the project as such, ask your questions on PAX!

Beware! File size limit on "portail" is 250MB. Make sure that your tp5.zip file size does not exceed 250MB.

Remerciements

Merci à Derek Hoiem et Kevin Karsch d'avoir créé le TP original qui a servi d'inspiration pour celui-ci!

Thanks

Many thanks to Derek Hoiem and Kevin Karsch for creating the assignment which inspired this one!